|

|

前言

本文有部分内容是直接来自网上,参考来源都有给出(为什么不用自己的话来重新写一遍呢?懒...还有就是前人已经写得很好了)。无心冒犯,若有侵权请告知。

时间有限,这篇文章仅介绍最新的一些 UNet 模型,更丰富的 UNet Family 可以参考:

P.S. taigw 这篇 UNet 的总结(2019)写得已经很好了,但没有跟进最新的一些成果,如 KiUNet、TransUNet 等。

所以这篇文章也可以看做是上面这篇的补充吧。

2018:Res-UNet 和 Dense-UNet

Res-UNet:https://ieeexplore.ieee.org/document/8589312/

Dense-UNet:Fully Dense UNet for 2-D Sparse Photoacoustic Tomography Artifact Removal

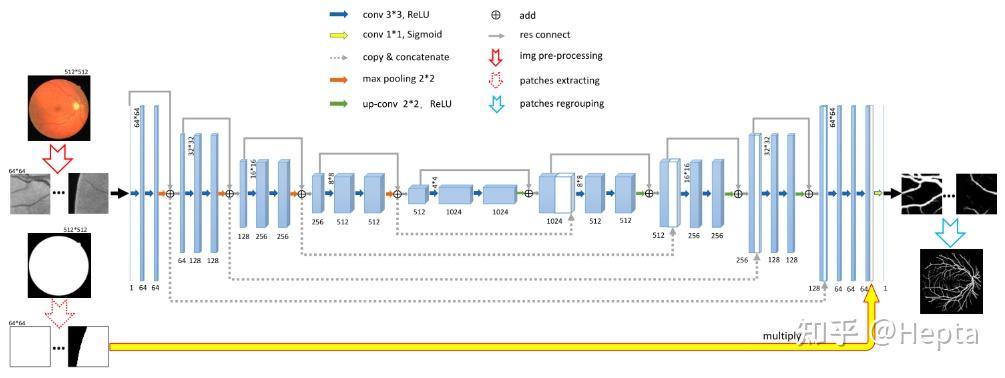

参考:taigw:图像分割的U-Net系列方法 Res-UNet 和 Dense-UNet 分别受到残差连接和密集连接的启发,将 UNet 的每一个子模块分别替换为具有残差连接和密集连接的形式。Res-UNet 用于视网膜图像的分割,其结构如下图所示,其中灰色实线表示各个模块中添加的残差连接。

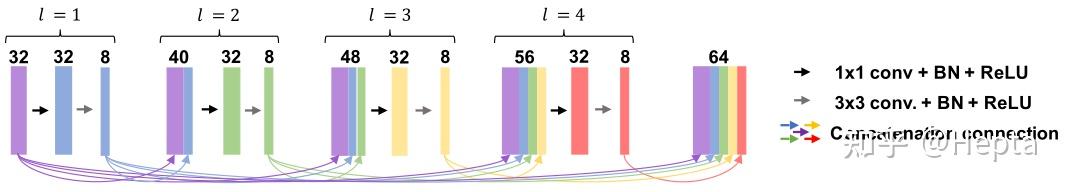

密集连接即将子模块中某一层的输出分别作为后续若干层的输入的一部分,某一层的输入则来自前面若干层的输出的组合。下图是 Dense-UNet 中的密集连接的一个例子。该文章中将 U-Net 的各个子模块替换为这样的密集连接模块,提出 Fully Dense UNet 用于去除图像中的伪影。

2019:ResU-Net++

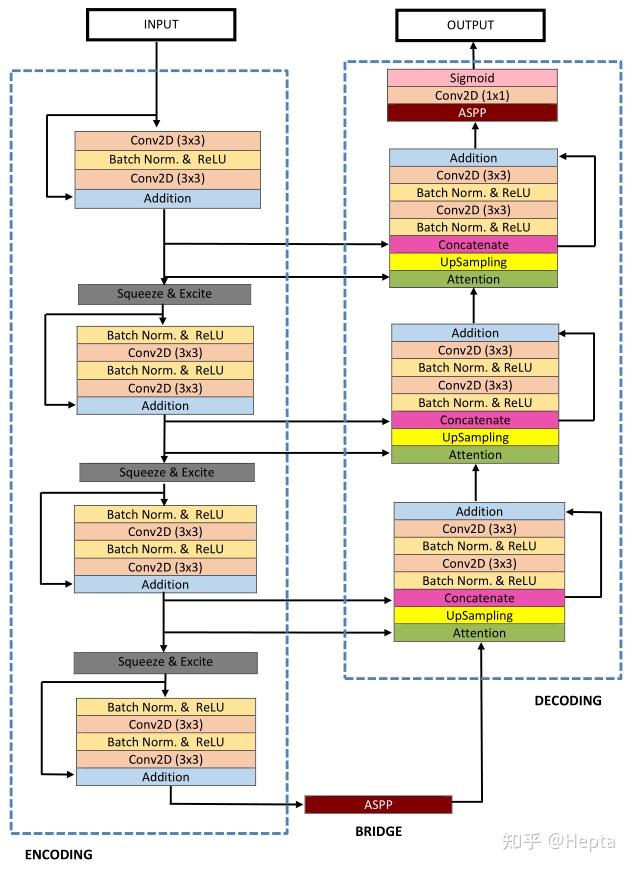

论文:ResUNet++: An Advanced Architecture for Medical Image Segmentation ResU-Net++ 是在 ResU-Net 基础上的改进。

如果说 ResUNet 是结合了 ResNet 和 UNet 的优势,那么 ResUNet++ 就是在 ResUNet 的基础上,继续引入 squeeze and excitation block,ASPP 和 attention block。

整体架构如下图所示(U 形),

再次感受到了深度炼丹的暴力美学。。。

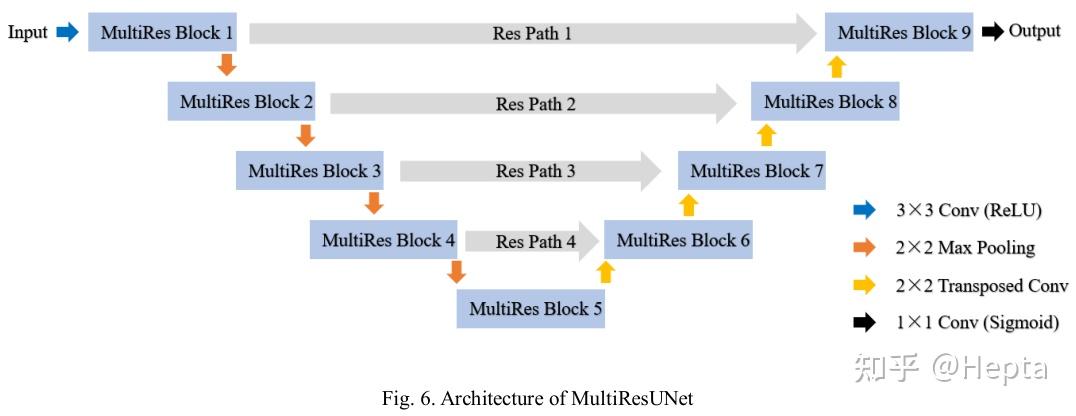

2019:MultiResUNet

论文:https://arxiv.org/pdf/1902.04049v1.pdf

代码:nibtehaz/MultiResUNet

参考:taigw:图像分割的U-Net系列方法 两点创新:

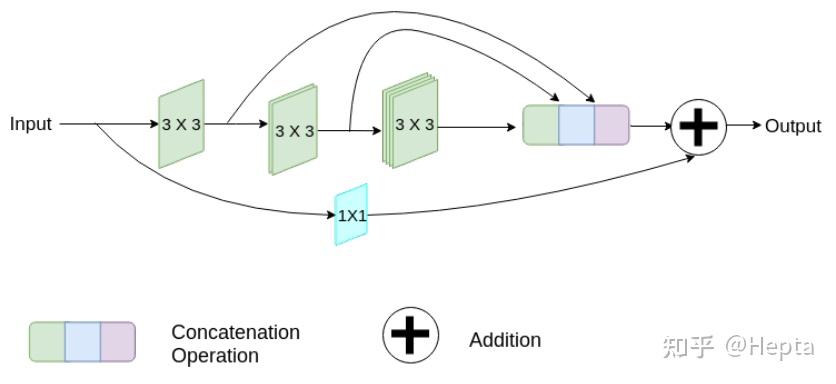

1. 使用 MutiRes 模块替换 UNet 中的传统卷积模块。

2. 使用 ResPath 替换传统 UNet 中的简单的 skip connection。

MutiRes 模块见下图,是一个残差连接的扩展,在该模块中三个 3x3 的卷积结果拼接起来作为一个组合的特征图,再与输入特征图经过 1x1 卷积得到的结果相加。

注:MutiRes block 启发于 Inception,论文中给出了设计的思路。

使用 MutiRes block 替换 UNet 中对应的 block,

注:上图来源于论文 DC-UNet(为什么不使用原论文的图呢?额。。)

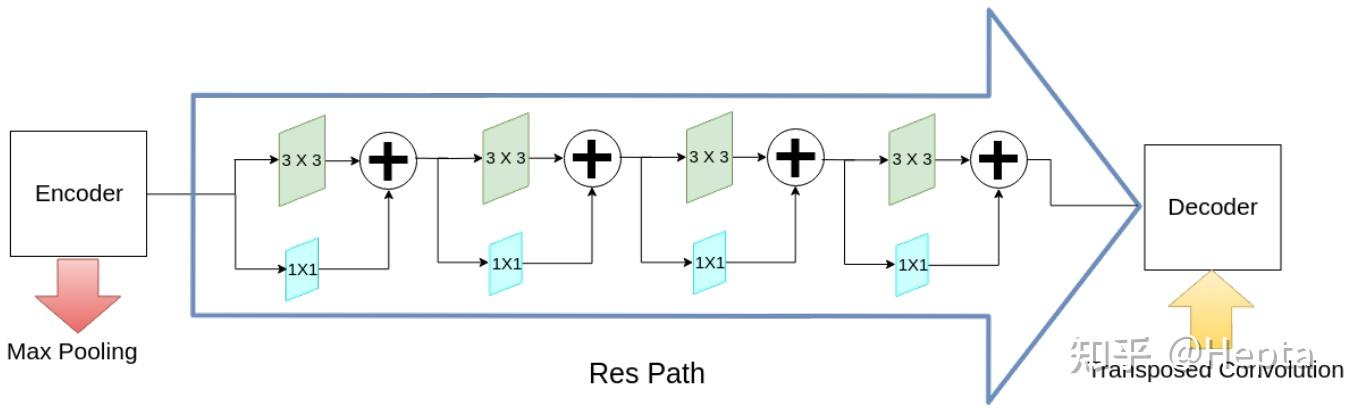

接着说残差路径 (ResPath)。

作者认为编码器中的特征由于卷积层数较浅,是低层次的特征,而解码器中对应的特征由于卷积层更深,是较高层次的特征,二者在语义上有较大差距,推测**不宜直接将二者进行拼接(skip connection and concat)**,而应该进一步使用卷积进行处理。并且根据深度的不同(ResPath1, 2, 3, 4)分别使用不同数量的卷积层(4, 3, 2, 1)。

该论文在 ISIC、CVC-ClinicDB、Brats 等多个数据集上验证了其性能。

2019:nnU-Net

论文:http://arxiv.org/abs/1904.08128

参考: 张良怀:nnUnet论文解析 nnU-Net 没有提出新的网络结构(仅在 UNet 的基础稍微改动),没有抓人眼球的地方,仅依靠一些技巧,将分割任务进行了大统一,在 10 个数据集上都取得了比较好的成绩。

目前为止 nnUNet 的代码已经被很多地方使用并且证明了它的效果,这不禁引起我们的深思,确实网络结构在这么多年来的所谓的创新,是不是真的都只是过拟合,都是论文作者的一厢情愿。

在没有充分的理论支撑的情况下,越是复杂的东西,就越容易过拟合,不是没有道理的。在深度学习领域的钻研方向问题上,学术界是不是走了很多弯路?更多的精力放在理解数据上(预处理、训练和推理策略、后处理等),可能更能得到大的提升。

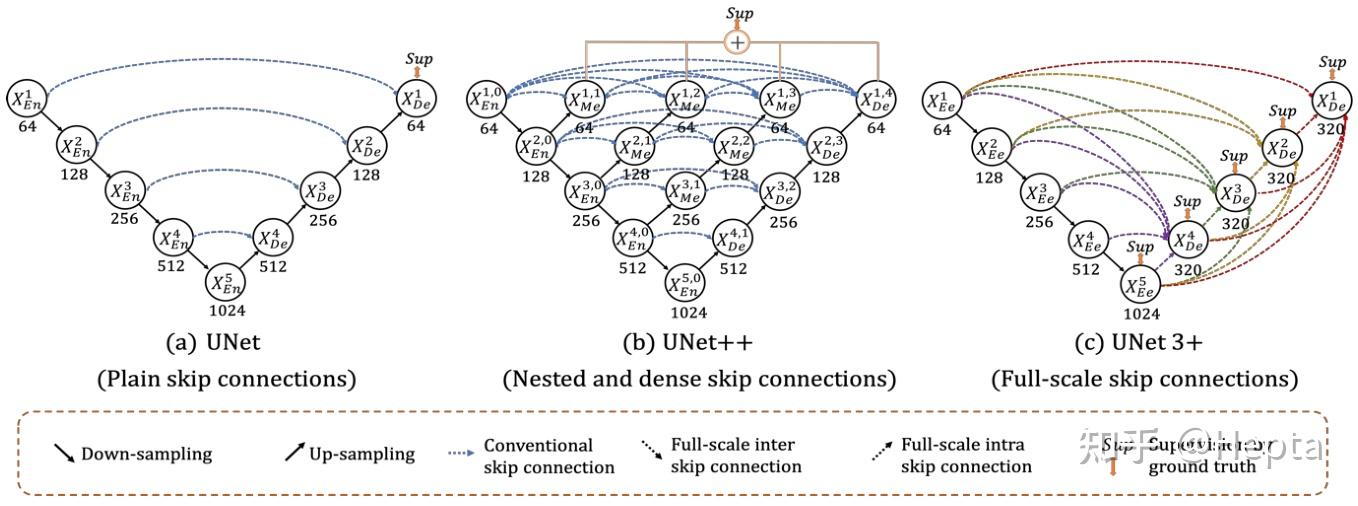

2020:UNet 3+

论文:https://ieeexplore.ieee.org/document/9053405/ UNet 3+ 是 2018年 UNet++ 的一个改进。

对 UNet++ 感兴趣可以参考其作者周纵苇分享的报告:

UNet 3+ 认为 UNet++ 尽管使用了密集的跳跃连接,但它没有充分利用好多尺度的信息,因此 UNet 3+ 提出了 full-scale skip connections,如下图,一目了然。

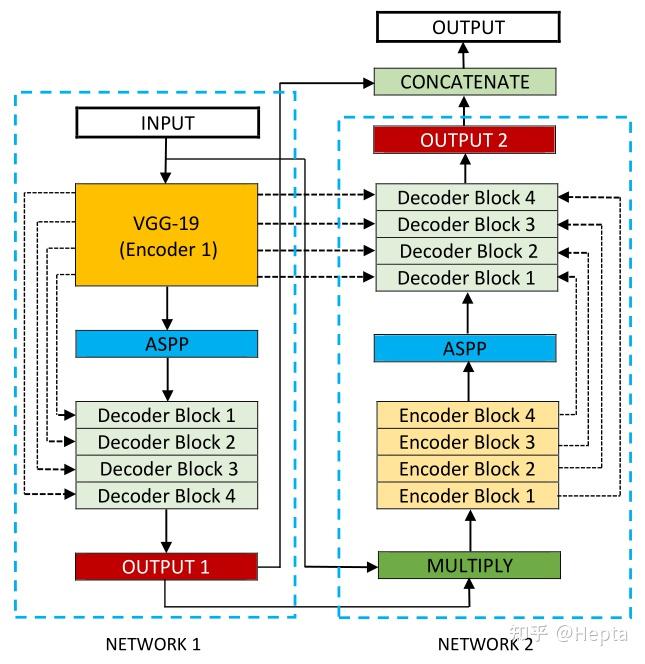

2020:Double U-Net

论文:http://arxiv.org/abs/2006.04868 Double U-Net 的架构如下,

等等!这熟悉的配图风格以及 ASPP,难道...!果然,和 ResUNet+ 的作者(Debesh Jha)是同一批人。

然后捋一遍 Double U-Net 的思路。

Double U-Net,顾名思义,就是有两个 U-Net 啦(上图的两个蓝色虚线框)。

这两个 U-Net 并不单纯是串联关系,

- 第一个 UNet 的 Encoder 和 第二个 UNet 的 Decoder 有 skip connections,

- 存在一个 MULTPLY 的过渡操作,

- 网络最终输出由两个 UNet 的 outputs concat 得到。

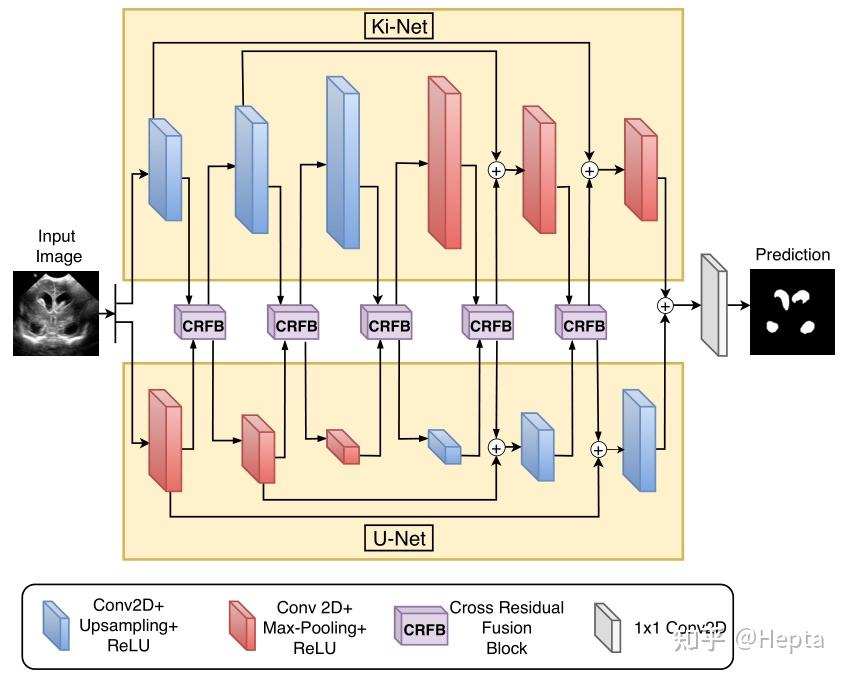

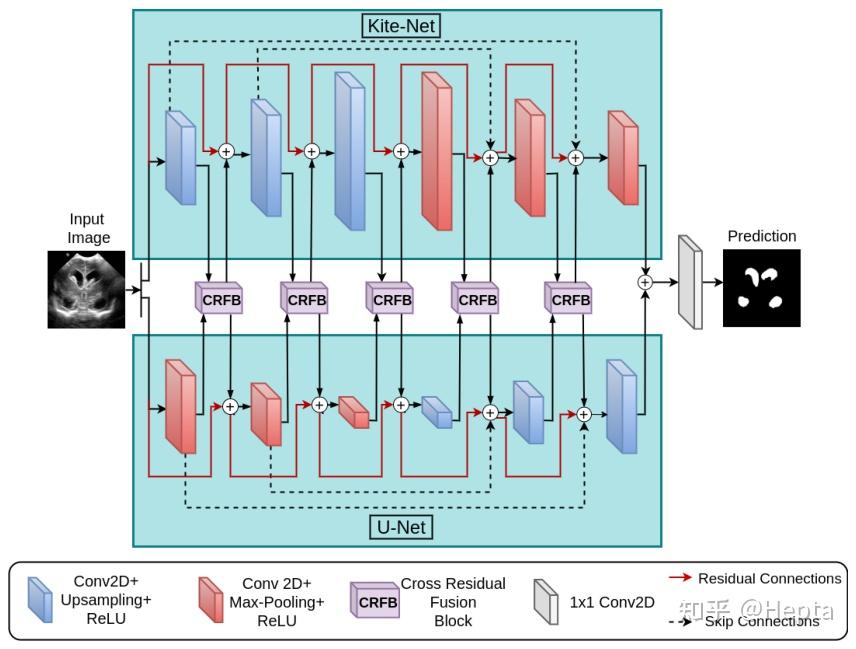

2020:KiU-Net

论文:KiU-Net: Overcomplete Convolutional Architectures for Biomedical Image and Volumetric Segmentation KiU-Net 的标题是 Overcomplete Convolutional Architectures for Biomedical Image and Volumetric Segmentation。可以获取两个信息,一是过完备卷积网络架构,二是 KiU-Net 是一篇诚意之作,在 2D 和 3D 数据上都有探索。

那什么是过完备(Overcomplete)呢?在信号处理中,指的是基函数的个数超过输入信号的采样个数,以减少信息丢损,同时也有利于发掘数据中的结构。

In signal processing, overcomplete representations [43] were first explored for making dictionaries such that the number of basis functions can be more than the number of input signal samples. 提出过完备的原因是,我们认为 UNet 中的 encoder-decoder 架构是导致在一些任务中出现小目标丢失、模糊对象边缘不准确等现象的罪魁祸首。

为了缓解这一点,我们在一般的 UNet 的基础上加了另外一个分支,Ki-Net,一种过完备的 CNN 架构。

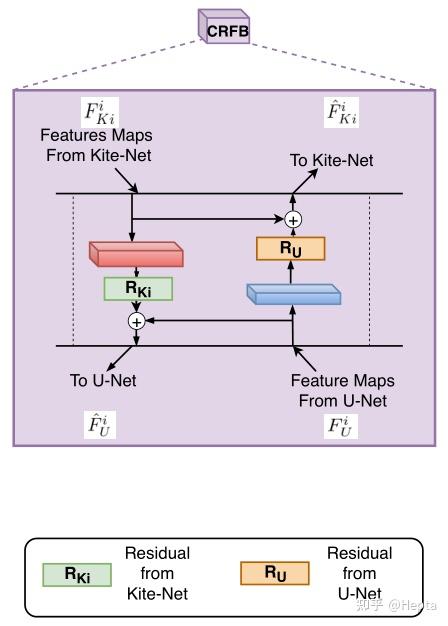

两个分支在前向传播的过程中,通过 CRFB 完成信息交流。

CRFB 的全称是 Cross Residual Fusion Block,交叉残差融合模块。细节如下。

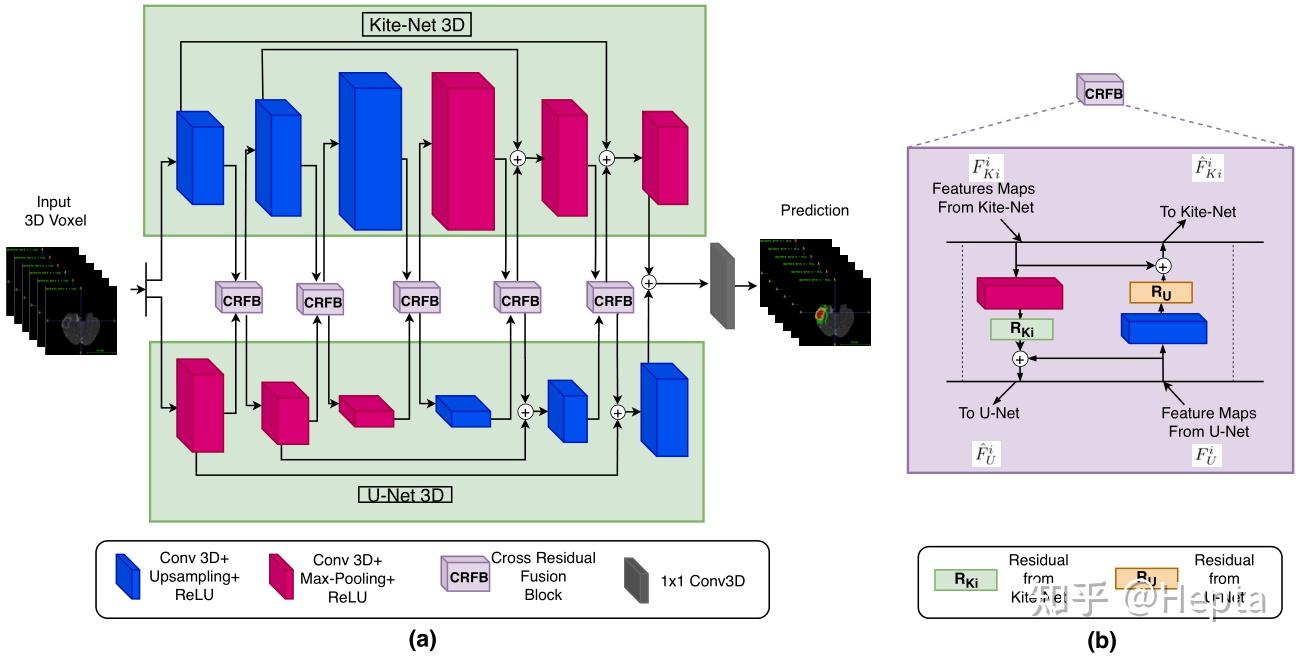

以上是 KiUNet 2D。论文中还提出了 KiUNet 3D,总体来说和 2D 的架构类似。

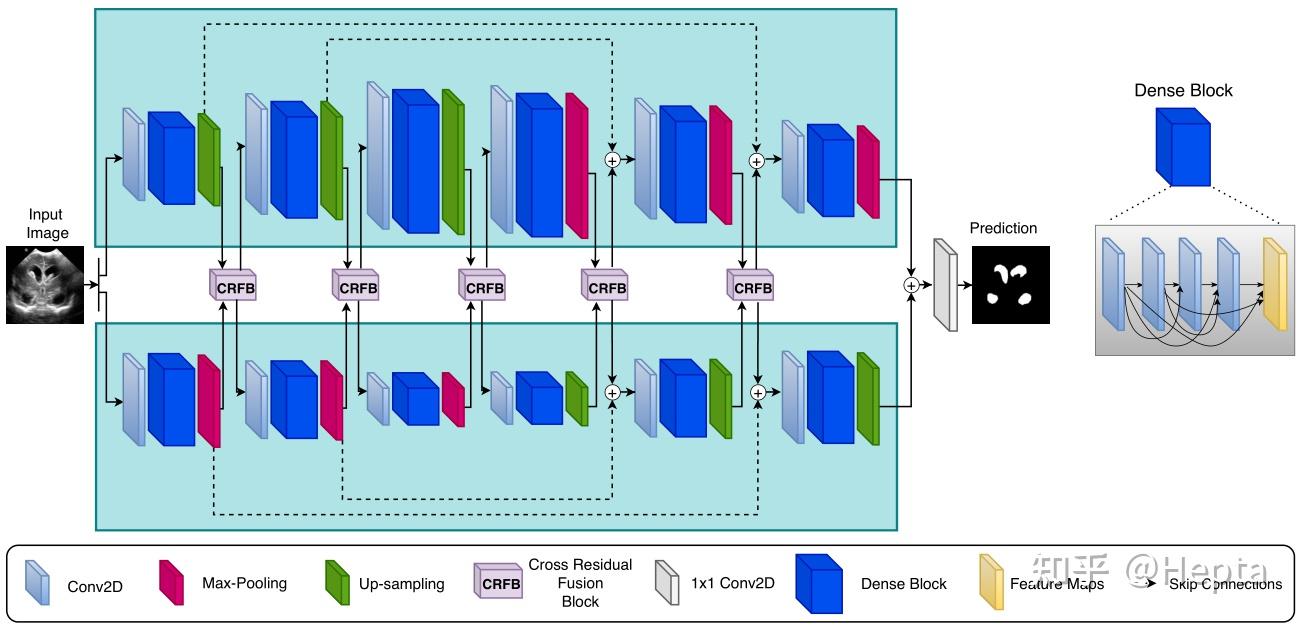

此外,我们还探索了 Dense-KiU-Net,

和 Res-Kiu-Net(你还想喝汤?hh,锅都给你掀了),

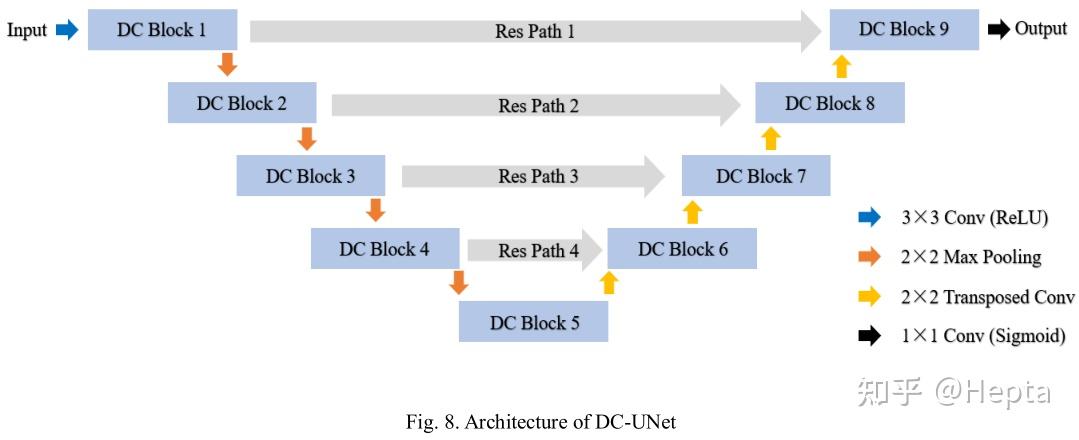

2020:DC-UNet

论文:DC-UNet: Rethinking the U-Net Architecture with Dual Channel Efficient CNN for Medical Images Segmentation DC-UNet 的全称是 Dual Channel U-Net。

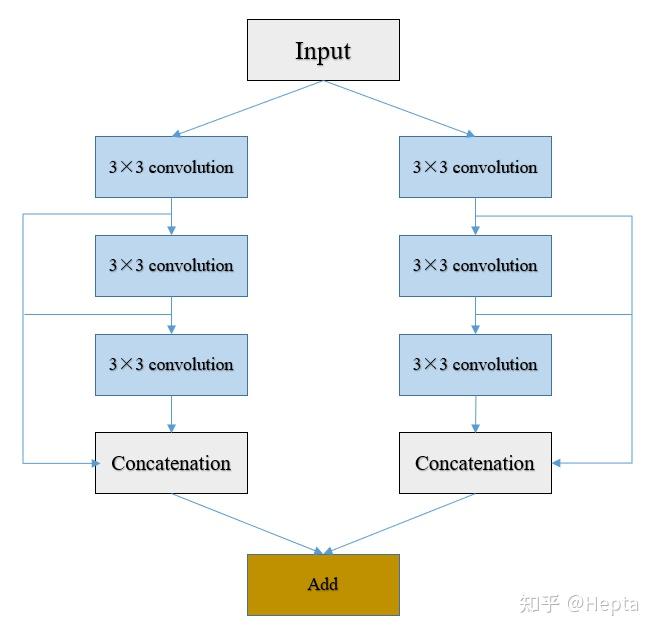

使用 DC block 替换 MultiResUNet 中的 MultiRes block,即 DC-UNet,

DC block 如下,看起来直觉就是两个 MultiRes block 加在一起。

比怎么做更重要的是,为什么要这样做?

DC-U-Net 的作者认为多尺度的信息有利于分割精度的提升(废话),一条 MultiRes block 提供的信息不够丰富,那...就两条!

To compare the segmentation results from the classical U-Net and MultiResUNet, we can easily find that different-scale features greatly help segmentation. Thus, we assumed that those most challenging tasks would be solved if we can provide more different-scale (more effective) features.

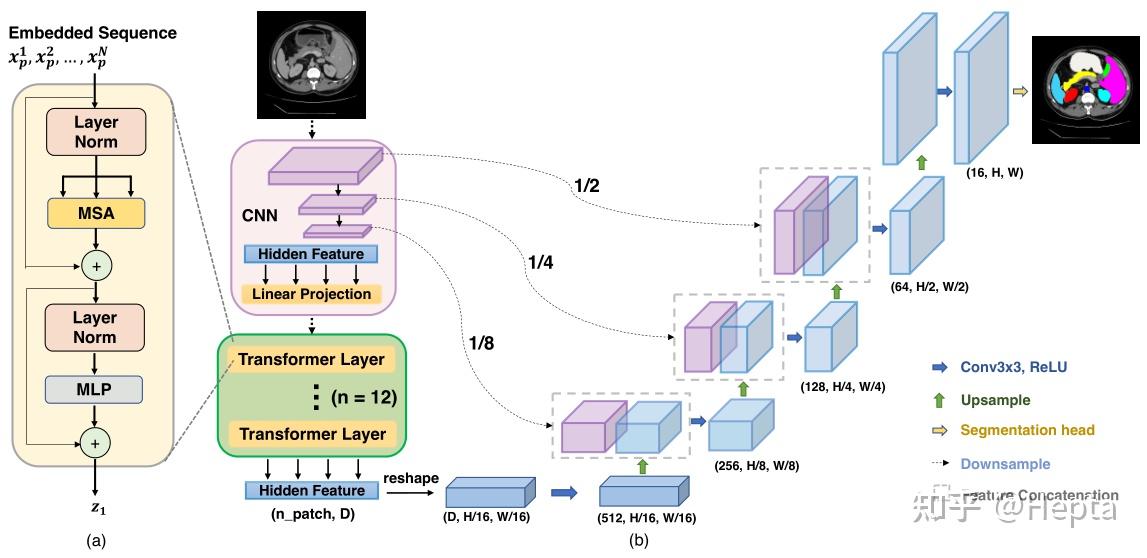

Based on this assumption, we noticed there was a simple residual connection in the MultiRes block. As the author mentioned, the residual connection here only provides a few additional spatial features, which may be not enough to some most challenging tasks. 2021:TransUNet

论文:http://arxiv.org/abs/2102.04306 我们认为,尽管 U-Net 系列网络已经取得了很大的成功,但存在一个问题:它们无法进行长距离依赖建模。这个问题的本身是 CNN 带来的。因此,我们我们将 Transformer 引入到 UNet 中。

TransUNet 架构如下,

Fig.1: Overview of the framework. (a) schematic of the Transformer layer; (b) architecture of the proposed TransUNet.

客观地说,TransUNet 没有使用 Transformer 完全替换掉 UNet 中的 CNN。相反,而是将 Transformer 作为一个中间件,完成长距离依赖建模,其它与一般的 UNet 架构并没有什么很大的差异。

总结

UNet 是一个经典的网络设计方式,在图像分割任务中具有大量的应用。也有许多新的方法在此基础上进行改进,融合更加新的网络设计理念,但目前几乎没有人对这些改进版本做过比较综合的比较。由于同一个网络结构可能在不同的数据集上表现出不一样的性能,在具体的任务场景中还是要结合数据集来选择合适的网络。

注:这段话复制自

19 年的现在仍然适用,hh

碎碎念:第一次体验知乎的编辑器,不支持 markdown 真的很难用。。

欢迎交流,若有错漏,恳请指出。

参考

1. 图像分割的U-Net系列方法 - taigw的文章 - 知乎 taigw:图像分割的U-Net系列方法

2. 论文笔记:用于医学图像分割的卷积网络(U-net) - 谭庆波的文章 - 知乎 谭庆波:论文笔记:用于医学图像分割的卷积网络(U-net)

3. nnUnet论文解析 - 张良怀的文章 - 知乎 张良怀:nnUnet论文解析 |

|